人工智能技術的飛速發展引發廣泛討論,特別是當一些系統展現出在特定任務上的超人類能力時,許多人擔憂:人工智能是否會全面超越人類智慧,甚至失控?針對這一議題,相關領域的專家指出,雖然人工智能在數據處理、模式識別等方面已表現出顯著優勢,但人類有能力通過倫理規范、法律框架和技術設計來有效約束它。

人工智能的“超人類”表現主要體現在狹窄領域,如棋類游戲、圖像分類或語言生成,這些系統依賴于大量數據和特定算法,缺乏人類的通用智能、情感理解和道德判斷。專家強調,當前的人工智能仍處于弱人工智能階段,其行為受限于預設的目標和訓練數據,無法自主形成意圖或價值觀。

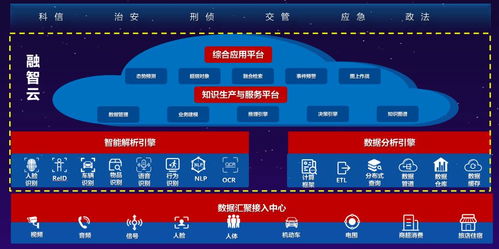

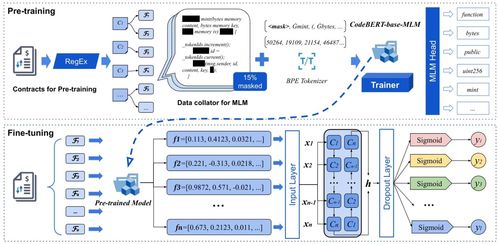

在人工智能應用軟件開發中,人類已開始整合約束機制。例如,開發者通過算法透明度、可解釋性工具和公平性檢查,確保系統決策不偏離人類價值觀。國際組織和政府正推動制定AI倫理準則,要求軟件必須遵循安全、隱私和非歧視原則。在實踐層面,諸如“紅隊測試”和持續監控被用于識別和糾正潛在風險。

專家還提到,人類可以通過設計“對齊”技術,使人工智能目標與人類利益一致。例如,在開發過程中嵌入人類反饋循環,讓系統學習并優先考慮用戶安全和社會福祉。跨學科合作——包括計算機科學、哲學和社會學——有助于構建更全面的監管體系。

盡管人工智能可能在某些方面超越人類,但通過 proactive 的軟件開發策略和全球協作,人類完全有能力引導其發展,確保技術服務于社會,而非構成威脅。關鍵在于持續投資于研究、教育和政策制定,以建立一個負責任的人工智能生態系統。